[가상메모리:SWAP] 건드리면 터지는 2GB 서버에 서비스올리기

·

컴퓨터구조 & OS

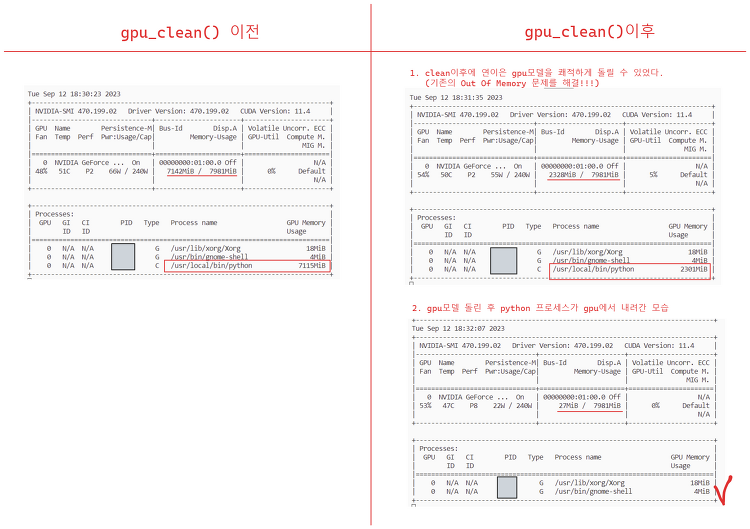

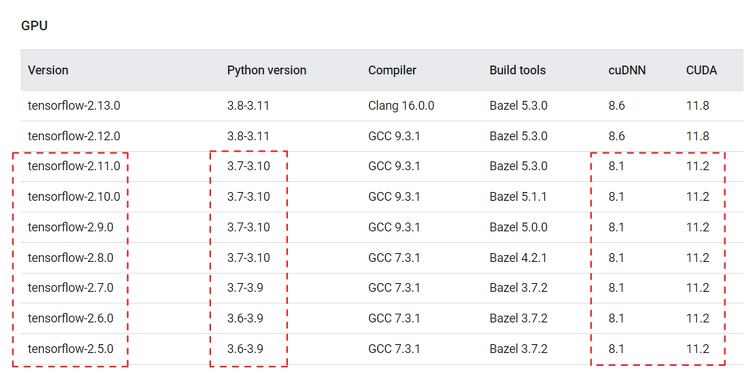

✨ 가상 메모리어떻게든 올려야 한다면 가상메모리(swap)를 고려해볼 수 있다!물리적 RAM이 부족할 때 디스크 공간의 일부를 RAM처럼 사용할 수 있게 하는 시스템이 가상메모리이다. 스왑 영역을 늘린다는 것은, 우리 서비스 프로세스에 필요한 페이지를 RAM에 다 못올리니까 보조기억장치(스왑영역)에 적재해두겠다는 것이다. RAM이 작으니까 페이지 폴트가 무지하게 발생하는 것이므로... 디스크의 스왑 영역을 빈번하게 참조(read, write)하게 된다. 결국 디스크 I/O 연산이므로 CPU 부하를 증가시킨다. 이 방법은 잠시 서비스를 돌리기 위한 임시 방편이다.우리 팀이 지원받고 있던 서버가 종료되어서..임시로 2GB 클라우드 서버 만들어서 올려두기로 했기 때문이다 (잠시!) ✨ 스왑 용량 늘리기시작..